به گزارش مجله آموزشی صلح خبر جدال با پینوکیو در شبکههای اجتماعی روزنامه همشهری: قرار است برنامههای ویژهای برای جلوگیری از تولید و انتشار اخبار جعلی یا آنطور که در دنیا مشهور است، «فیکنیوز» شکل بگیرد. وزیر ارتباطات اخیرا گفته سامانهای برای کنترل اخبار جعلی توسط پژوهشگاههای وزارت ارتباطات و فناوری اطلاعات برای کمک به […]

به گزارش مجله آموزشی صلح خبر

جدال با پینوکیو در شبکههای اجتماعی

روزنامه همشهری: قرار است برنامههای ویژهای برای جلوگیری از تولید و انتشار اخبار جعلی یا آنطور که در دنیا مشهور است، «فیکنیوز» شکل بگیرد. وزیر ارتباطات اخیرا گفته سامانهای برای کنترل اخبار جعلی توسط پژوهشگاههای وزارت ارتباطات و فناوری اطلاعات برای کمک به سواد رسانهای در حال طراحی است که میتواند بفهمد منبع یک خبر موثق است یا نه؟ در عین حال، وزیر ارشاد نیز اعلام کرده، بهزودی با دستگاهها و وزرای دیگر جلساتی برگزار میشود تا درباره لزوم حمایت مالی از استارتاپهای این حوزه برای رشد سواد رسانهای بحث شود.

این اخبار جعلی که عموما در سایتهای بینشان یا شبکههای اجتماعی پخش میشود، یکی از منابع گسترش شایعه بهخصوص در مواقع بحران است. ابزارهای فناورانه، هوش مصنوعی و از همه مهمتر، آگاهیبخشی عمومی میتواند جلوی این مشکل را تا حد زیادی بگیرد.

باتهای مزاحم

یکی از متداولترین راهها برای پخش «خبر جعلی» استفاده از باتها در شبکههای اجتماعی است. این باتها معمولا طوری برنامهریزی میشوند که اخبار یا دادههای یکسان را در سطحی گسترده پخش کنند. بعضیهایشان نیز میتوانند کارهای دیگری مثل جذب مخاطب، لایک کردن و… انجام بدهند. این باتها میتوانند پیامهای افراد عادی و حسابهای واقعی را نیز در سطحی گسترده پخش کنند؛ طوری که یک پیام ساده توسط کاربران زیاد در مدتی کوتاه دیده شود.

شناسایی این باتها و جلوگیری از فعالیت آنها وقتی با چند بات ساده طرف باشیم، کار دشواری نیست. باتها معمولا ظاهر و کارکرد مشخصی دارند و پیامهای یکسانی را در شبکهها پخش میکنند، اما وقتی تعدادشان از حد مشخصی بالاتر برود و چند دسته پیام مختلف ارائه کنند، شناسایی و بند آوردنشان ساده نخواهد بود. فیسبوک اخیرا از یک فناوری «ضدبات» رونمایی کرده و توضیحات مختصری هم درباره اینکه چنین فناوریای با استفاده از هوش مصنوعی کار میکند، ارائه داده، اما بهخاطر مسائل امنیتی درباره جزئیات کارکردش اطلاعات زیادی در دسترس نیست.

بهطور کلی، این سیستمهای مبتنی بر هوش مصنوعی با آنالیز کردن رفتار باتها، نوع نوشتههایی که پخش میکنند و چگونگی کارکردشان در شبکه نمونههای «اسپم» و مزاحم را شناسایی میکنند. هوش مصنوعی این قابلیت را دارد که با دریافت نمونههای جدید آموزش ببیند و میتواند به مرور باتهای پیچیده را شناسایی کند.

پیدا کردن منبع خبر جعلی

شناسایی اخبار جعلی و بند آوردن مسیر تولید آنها نیز از مسائل دیگری است که هوش مصنوعی میتواند جلوی آن را تا حدی بگیرد. از نظر تئوری ماشین شیوه بیان یک نوشته را بهعنوان پایه درنظر گرفته و هرچیزی که شبیه آن باشد را بهعنوان خبر یا نوشته جعلی شناسایی میکند. اما شیوه بیان یا نوشتن انسان میتواند بسیار متفاوت باشد و از نظر ظاهری در طبقهبندی هوش مصنوعی جای نگیرد.

برای جلوگیری از رخ دادن چنین مشکلی، هوش مصنوعی جزئیات دیگری مثل نشانی سایت و ظاهر آن را نیز بررسی میکند. برای بهتر شدن شیوه کارکرد هوش مصنوعی به کمک اپراتور انسانی یا کاربران شبکههای اجتماعی نیاز جدی وجود دارد که بهصورت دستی نمونههای خبر جعلی را به هوش مصنوعی نشان بدهد و آن را تقویت کند.

مقابله با اخبار جعلی با بلاکچین

فناوری زنجیرهای یا بلاکچین میتواند به شفافیت روند پخش اخبار کمک کرده و در نتیجه، جلوی تولید و انتشار اخبار جعلی را بگیرد. در این سیستم، از نظر فنی میتوان منبع خبر را بررسی کرد و فهمید که هر بخش از خبر از کجا نقل شده است. سیستم بلاکچین میتواند به ساخت پلتفرمهای اجتماعی منجر شود که در آنها امکان سنجش درست یا غلط بودن اخبار وجود دارد.

مبارزه با ویدئوهای جعلی

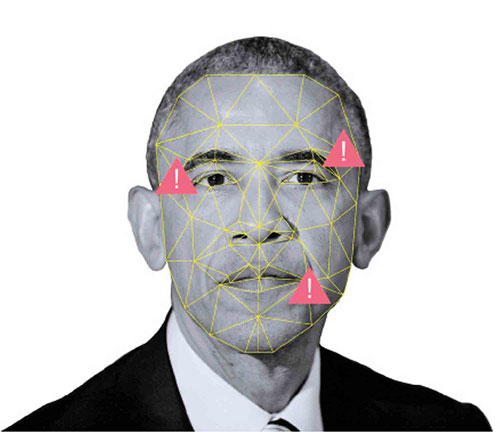

ویدئوهای جعلی یا «دیپفیک» نمونههایی از دادههای جعلی هستند که میتوانند تصویر و صدای یک نفر را تقلید کرده و آن را تا حد زیادی شبیه نمونه اصلی بازسازی کنند. فناوری ماشینی میتواند این نوع از ویدئوها را با بررسی چهره شخصیت اصلی و آنالیز کردن شیوه رفتار او بررسی کند. نقطه ضعف این ویدئوهای جعلی در چشمهای گوینده وجود دارد، چون جزو بخشهایی از صورت گوینده است که معمولا در ویدئوهای جعلی و اصلی وجود دارد. شیوه متفاوت پلک زدن گوینده در ویدئوهای جعلی و اندازه غیرعادی مردمک چشم از مواردی است که در شناسایی ویدئوهای «دیپفیک» به هوش مصنوعی کمک میکنند.

اخیرا ویدئویی از اوباما در شبکههای اجتماعی منتشر شد که او را در حال بیان جملاتی عجیب نشانمیداد. این ویدئو با کمک فناوری دیپفیک و با کمک هوش مصنوعی حالات او را تقلید کرده بود.

بهانه برای سانسور

برخی کارشناسان میگویند، مقابله با اخبار جعلی و مبارزه با باتها در برخی کشورها وسیلهای برای پخش گزینشی اخبار شده است. یکی از آخرین نمونهها به اینترنت داخلی روسیه برمیگردد که مقامات این کشور گفتهاند یکی از کاربردهای مهمش جلوگیری از پخش اخبار جعلی و کاربران غیرواقعی است. اما بسیاری از کارشناسان ایرادهای فنی جدی به این موضوع وارد کرده و آن را صرفا یک بهانه برای کنترل اینترنت از سوی این کشور میدانند.

ازجمله «زاک دافمن»، تحلیلگر حوزه فناوری نشریه فوربس در این باره به همشهری میگوید: «آنچه با عنوان «اخبار جعلی» از آن نام برده میشود، نیاز به بررسی و داوری دقیقتری دارد. برای اینکه بفهمید یک خبر، جعلی یا واقعی و درست یا غلط است، به یک سیستم داوری نیاز دارید. در بسیاری موارد مشخص نیست، چه فرد یا سیستمی تصمیم میگیرد یک محتوا باید جزو اخبار جعلی طبقهبندی بشود یا نه.»

منبع : Bartarinha